« Oh mince, mon client n’a plus accès à ses data centers, et on ne sait pas d’où ça vient. » Voilà le cauchemar de tout consultant en gestion de réseau… Pour éviter ce type de situation, les grandes organisations doivent répondre à des attentes croissantes en matière de disponibilité et de performance des systèmes d’informations. C’est là qu’intervient le NetOps – une approche qui s’appuie sur des outils d’observabilité et d’automatisation pour permettre aux équipes IT de gérer les systèmes réseaux de façon proactive. Avec des infrastructures de plus en plus complexes, le NetOps est aujourd’hui indispensable pour garantir la fiabilité des réseaux, leur capacité à supporter une grande charge et à s’adapter rapidement aux changements.

La gestion des logs et le reporting jouent ici un rôle fondamental. Ces outils offrent aux équipes IT une vision globale de l’état des systèmes, leur permettant non seulement d’anticiper les pannes, mais aussi d’identifier des opportunités d’amélioration. Composants essentiels du NetOps, ils donnent accès à l’état interne d’un système réseau – que ce soit un serveur, une base de données, ou des équipements réseau – en analysant les signaux externes comme les logs, les métriques et les traces.

Mais c’est quoi exactement, les logs et le reporting ?

Les logs, ou « fichiers de journalisation », sont des enregistrements automatiques des événements qui se produisent au sein d’un système. Pourquoi c’est utile ? Parce qu’ils fournissent un historique, facilitent la surveillance et aident à résoudre les problèmes rapidement.

Le reporting, de l’autre côté, consiste à collecter, analyser et présenter des données pour donner des insights, générer des alertes et permettre des décisions data-driven – Ces processus sont essentiels pour garantir la qualité des systèmes et soutenir les équipes IT dans leur gestion quotidienne.

Cependant, il peut être difficile de s’y retrouver face à la multitude d’outils de gestion des logs disponibles sur le marché. Comment choisir celui qui correspondra le mieux à vos besoins ? Dans cet article, on vous propose un benchmark des principaux outils de gestion des logs : Splunk, Datadog et Elastic. Notre objectif est de vous fournir toutes les informations nécessaires pour vous aider à faire le choix le plus pertinent.

Ensuite, on va identifier, étape par étape, les moments du processus de gestion des logs où l’IA pourrait vraiment nous apporter une aide dans le futur proche. Comment l’IA peut intervenir à chaque niveau, de la collecte et de l’analyse des logs jusqu’à la création de tableaux de bord ?

C’est ici que les choses deviennent intéressantes : imaginer comment ces technologies pourraient simplifier le travail au quotidien tout en transformant la manière de gérer les incidents et d’anticiper les problèmes.

Comment choisir le meilleur outil de gestion de log ?

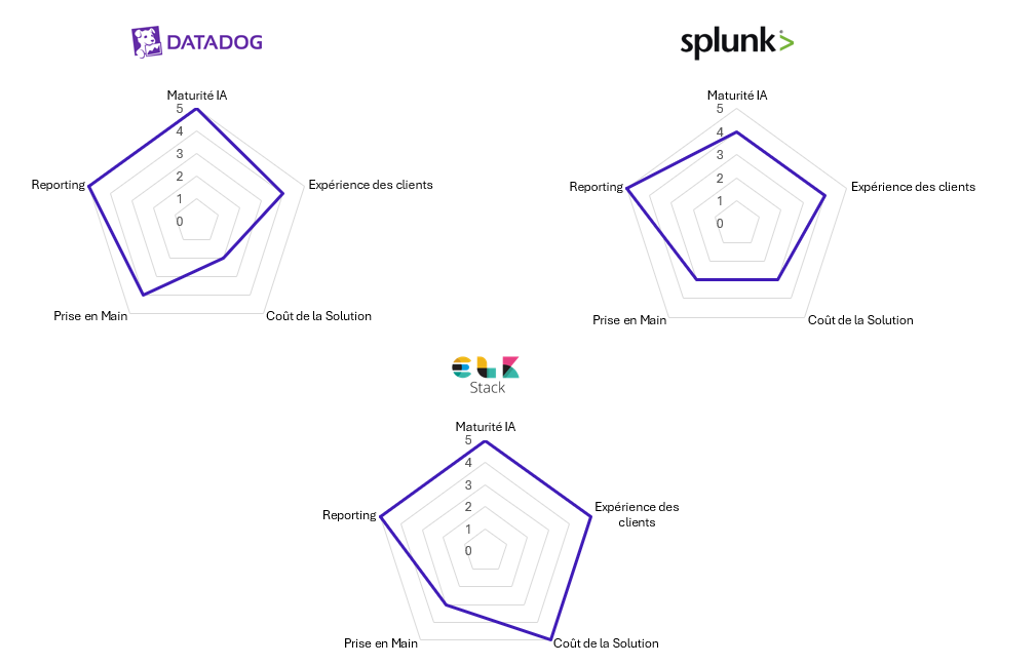

Pour nous guider dans le choix de l’outil le plus adapté, cinq critères ont été retenus afin d’évaluer les solutions sous différents aspects :

- L’expérience des clients : le logiciel est-il bien évalué par les clients ?

- La maturité de la solution d’IA : quel est l’état actuel de l’IA dans l’outil et quelles sont les perspectives de développement ?

- Le coût de la solution : le prix est-il pointé comme un problème par les utilisateurs ?

- La prise en main : le logiciel est-il facile à utiliser ?

- Le reporting : les fonctionnalités de reporting répondent-elles aux besoins des clients ?

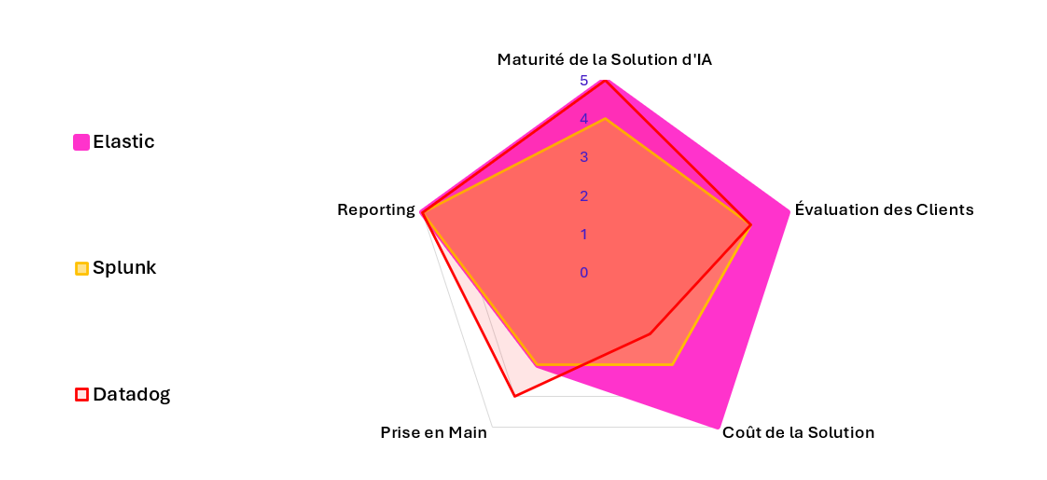

Les graphiques ci-dessous présentent les résultats de l’évaluation sur ces cinq critères, notés de 1 à 5.

Fig. 1 – Résumé de l’évaluation des solutions (basée sur Gartner et G2)

Fig. 2 – Vue d’ensemble des évaluations de solutions (basée sur Gartner et G2)

- Datadog : offre de bonnes performances en matière de maturité de l’IA et de reporting, notamment grâce à son assistant Bits AI qui fournit des solutions automatisées pour identifier et résoudre les problèmes dans les données telles que les logs et les métriques. La plateforme est appréciée pour ses fonctionnalités de monitoring et sa facilité d’utilisation. Cependant, les coûts élevés suscitent des critiques, avec une tarification complexe composée de plus de 20 lignes de produits distincts, et une escalade des coûts à mesure que l’utilisation augmente.

- Elastic : se distingue dans la majorité des critères. La solution se démarque par ses capacités d’IA qui permettent la détection des anomalies (taux de pics de logs), la catégorisation des logs et la fourniture d’informations grâce à l’assistant d’observabilité. Le stack Elastic s’intègre facilement avec les services cloud comme AWS, Microsoft Azure et Google Cloud Platform, et offre une large gamme de connexions pour la collecte de logs. Elastic peut être plus difficile à maîtriser, en particulier lorsqu’il est auto-hébergé, en raison de la complexité à son implémentation sur site. De plus, bien que la solution soit open-source, l’option Elastic Cloud commence à partir de 175 USD par mois.

- Splunk : maintient une performance équilibrée sur tous les critères. Il propose une plateforme unifiée pour la sécurité et l’observabilité, incluant un assistant IA qui aide les utilisateurs à rédiger des requêtes et à détecter des anomalies. Les mises à jour récentes incluent des fonctionnalités améliorées du Machine Learning Toolkit, qui prennent désormais en charge les modèles externes et le traitement avancé du langage naturel. La complexité des modèles de tarification de Splunk, basés sur la charge de travail, l’ingestion des données, le nombre d’entités et l’activité, peut poser des difficultés aux utilisateurs. Splunk est apprécié pour ses fonctionnalités de gestion des logs, mais sa complexité peut être un point de friction.

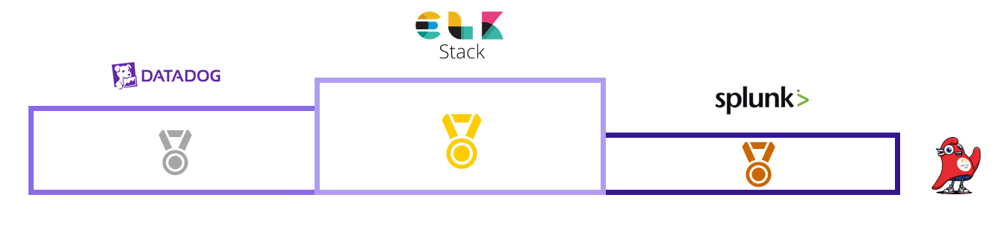

Ces résultats montrent qu’il n’existe pas une solution unique parfaite, mais plutôt des outils adaptés à des besoins spécifiques. Cependant, si nous voulons obtenir un classement, en calculant la moyenne simple des notes attribuées à chaque solution pour chaque critère, Elastic occupe la première place dans le benchmark, suivi de Datadog, et enfin de Splunk.

Fig. 3 – Classement des solutions évaluées

Ce benchmark permet de mettre en lumière les points forts de chaque outil, mais le choix final dépendra de la stratégie de votre organisation et des priorités que vous fixez pour vos systèmes. L’essentiel est de trouver l’outil qui optimisera votre gestion des logs en s’alignant sur vos objectifs opérationnels.

L’avenir des outils d’observabilité – Comment l’IA peut transformer la gestion des logs ?

L’ère de l’IA a complètement changé le fonctionnement des outils d’observabilité. Des investissements massifs par les fournisseurs ont été réalisés et les outils voient une intégration croissante des fonctionnalités d’intelligence artificielle, qui est devenue la priorité numéro 1 de développement. Aujourd’hui, on entre dans une nouvelle ère : celle de l’observabilité assistée par l’IA.

De la collecte à l’analyse – Les logs et la gestion des infrastructures IT

Aujourd’hui, la gestion des logs est un processus qui repose sur une série d’étapes qui permettent de collecter, traiter, analyser et interpréter les données des logs, afin de détecter des anomalies, diagnostiquer des incidents, et améliorer la fiabilité et la performance globale des infrastructures. Il rend possible de comprendre et de surveiller l’état des systèmes informatiques, qu’il s’agisse de serveurs, d’applications ou de bases de données.

Voici les principales étapes de ce processus :

- Identification et sélection des sources de logs :

-

- Détermination de quels systèmes et applications fourniront les logs (serveurs, applications, bases de données, etc)

- Installation des agents et transfert des logs :

-

- Installation des agents de collecte de logs sur les systèmes identifiés

- Parsing et indexation :

-

- Transformer et stocker les logs

- Analyse des logs :

-

- Identifier des anomalies ou tendances dans les données pour diagnostiquer des problème

- Recherche et requêtes :

-

- Effectuer des recherches avancées à l’aide de requêtes pour extraire des insights précis

- Création des dashboards et alertes :

-

- Concevoir des tableaux de bord visuels pour représenter les données des logs, et configurer des alertes pour répondre aux incidents détectés

À partir de l’étape 3, l’intelligence artificielle commence à intervenir dans toutes les étapes du processus. L’IA permet de simplifier la détection des problèmes, d’optimiser la recherche d’informations et d’automatiser la surveillance. Voici comment l’IA contribue à chacune de ces étapes :

Transformer le parsing des logs – Pourquoi l’IA surpasse les Regex

Actuellement, le parsing des logs repose principalement sur l’utilisation d’expressions régulières (Regex). Cependant, cette méthode présente plusieurs défis. Les expressions régulières doivent être ajustées pour correspondre aux différentes structures des logs et elles doivent être adaptées à chaque application et sa version. Les Regex sont également fragiles : un léger changement dans le format des logs, tel qu’une mise à jour logicielle ou une modification dans les systèmes, peut entraîner des erreurs dans le parsing.

L’IA offre une alternative plus robuste avec l’utilisation de modèles de reconnaissance d’entités nommées (NER), un sujet encore en phase de recherche et qui n’est pas implémenté dans les outils. Ces modèles sont entraînés pour extraire des informations à partir des logs, sans dépendre des structures strictes imposées par les Regex. Cette approche réduit le besoin d’ajustements manuels fréquents, rendant le processus plus adaptable aux évolutions des systèmes. En pratique, l’utilisation de l’IA pour le parsing des logs peut faire gagner jusqu’à deux heures* par personne lors de l’étape de configuration d’un outil de gestion des logs.

*en supposant qu’il faille 10 minutes pour la configuration par fichier et qu’elle doive gérer 12 fichiers log

Quand l’IA anticipe – Détection d’anomalies, prédictions et surveillance proactive

L’IA intervient dans trois domaines majeurs pour améliorer l’analyse des logs, la détection d’anomalies, l’analyse prédictive et le clustering des données :

- Détection d’anomalies : les modèles sont capables d’analyser de grandes quantités de données pour identifier des comportements inhabituels ou des déviations par rapport aux normes. En affinant les seuils d’alerte et en apprenant des incidents passés, l’IA réduit les faux positifs, ce qui diminue le nombre d’alertes inutiles

- Analyse prédictive : grâce à l’analyse des tendances historiques, les modèles prédictifs peuvent anticiper les problèmes avant qu’ils ne surviennent. Cela permet d’éviter les interruptions imprévues et les réparations coûteuses

- Clustering : en regroupant les données de logs ou les alertes selon des caractéristiques similaires, l’IA aide à identifier des motifs récurrents

Lorsqu’ils sont bien configurés et utilisés, ces trois types d’actions permettent non seulement de réduire le délai moyen de résolution (MTTR), mais aussi de diminuer le temps passé à parcourir manuellement les logs. De plus, les gains liés à l’évitement des défaillances peuvent être significatifs, avec un coût moyen estimé à 9 000 USD par minute de panne*, bien que ces économies soient parfois difficiles à quantifier précisément.

*coût des temps d’arrêt pour les grandes organisations

L’IA générative, a-t-elle sa place dans les outils d’observabilité ?

Écrire des requêtes de logs en langage naturel

Chaque outil de log possède son propre langage pour permettre la recherche d’informations à l’intérieur des fichiers. L’IA permet de traduire le langage naturel en langage de requête, ce qui signifie que les utilisateurs peuvent poser des questions en langage courant sans avoir besoin de connaître la syntaxe technique des requêtes. Par exemple, un analyste peut formuler une demande du type « Afficher les erreurs syslog critiques du mois dernier », et l’outil générera automatiquement la requête correspondante. Cela s’accompagne d’un gain de productivité qui réduit les heures qu’un analyste passe à écrire manuellement des requêtes et le libère pour des tâches à plus forte valeur ajoutée.

Également, l’IA peut expliquer le code en langage naturel, fournissant des explications pas à pas de la logique des requêtes. Cela est particulièrement utile pour les analystes juniors ou les utilisateurs moins expérimentés, qui peuvent ainsi mieux comprendre les requêtes pour effectuer leurs analyses.

Avec ces fonctionnalités, L’IA pour l’écriture des requêtes peut permettre à chaque utilisateur d’économiser près de 45 heures* par an et faciliter l’apprentissage pour les analystes juniors.

*en supposant qu’un analyste passe 2 heures par semaine en écrivant des requêtes, et que genAI peut lui apporter 40 % de productivité en plus (selon une étude menée par le MIT)

Des visuels instantanés grâce à l’IA

L’IA facilite également la création de visualisations à partir de conversations en langage naturel. Les utilisateurs peuvent demander des rapports spécifiques et obtenir des graphiques ou des tableaux instantanés à partir des données de logs. En plus de la création de visualisations, l’IA analyse les données pour identifier les motifs récurrents et les anomalies, fournissant des résumés et des propositions d’actions correctives.

L’IA, un incontournable pour l’avenir des outils d’observabilité

En observant l’évolution des fonctionnalités d’IA dans les outils de gestion des logs, on constate une adoption croissante des capacités d’analyse prédictive et descriptive, qui sont bien établies et largement utilisées. Cependant, on remarque que l’implémentation de l’IA générative varie encore considérablement selon les logiciels, certains ayant déjà fait le saut tandis que d’autres sont encore en phase exploratoire.

Pour nous, il est clair que l’intégration de technologies avancées basées sur l’IA va continuer à s’étendre, jusqu’à devenir une norme incontournable dans les solutions de monitoring et de reporting. À mesure que ces outils se perfectionnent, on va avoir une expérience utilisateur de plus en plus fluide, avec des gains en productivité qui feront une réelle différence au quotidien.

Alors, la prochaine fois que votre client appelle pour un accès perdu aux data centers, ces outils auront peut-être déjà réglé le problème avant même que le téléphone ne sonne.