Basée sur la première partie de cet article, consacrée aux concepts de base de l’intelligence artificielle, cette deuxième et dernière partie propose une prospective permettant d’éclaircir les enjeux de l’intelligence artificielle et son potentiel impact sur notre avenir.

L’approche proposée ici est une projection temporelle dans les prochaines décennies, pour tenter d’anticiper les problématiques fondamentales auxquelles nous pourrions être confrontés, et ce, notamment grâce aux travaux de réflexion déjà réalisés par d’éminents experts du monde des nouvelles technologies et de la science. Les idées et concepts qui en découlent sont accompagnés d’exemples tirés des dernières actualités, bien réelles cette-fois-ci.

Retour sur quelques actualités marquantes

Le développement des intelligences artificielles fait régulièrement la une de l’actualité high-tech, tant ses promesses sont fortes et les domaines d’utilisation variés.

Citons par exemple le très populaire réseau social Facebook qui a récemment annoncé le coup d’envoi de l’utilisation de son intelligence artificielle baptisée Deeptext. Il s’agit d’une intelligence artificielle développée dans le but d’analyser les textes écrits, et images postées, par ses utilisateurs, pour déterminer plus finement leurs centres d’intérêts et mieux s’approprier le langage humains et ses subtilités. Tout ceci permettant alors une catégorisation plus efficace des contenus publiés (et un ciblage publicitaire accru ?).

Passons le débat sur les ambitions parfois douteuses du réseau social, ce qui est intéressant de relever ici est qu’une société – brassant les conversations de plus d’un milliard d’utilisateurs – soit d’ores et déjà en train de développer une intelligence artificielle.

Imaginez un peu le potentiel de cette intelligence artificielle dans quelques années : pour peu qu’elle soit capable d’évoluer de façon régulière, elle pourrait devenir l’intelligence artificielle la plus pointue qui soit dans le domaine de l’analyse de textes et d’images, en brassant une quantité incroyable d’informations renouvelées chaque jour, lui permettant ainsi d’auto entretenir ses connaissances et de se perfectionner de façon continue et autonome.

Il existe une infinité de domaines dans lesquels les intelligences artificielles peuvent être exploitées. Parmi les plus impressionnants, il y a les robots anthropomorphiques (reproduisant l’aspect humain) dotés d’intelligence artificielle. C’est récemment la société Hanson Robotics qui s’est illustrée dans ce domaine en dévoilant sa création nommée Sophia. Ce robot humanoïde a été développé dans le but de se rapprocher le plus possible de l’apparence et du comportement (langage, expressions du visage) humain.

Le résultat est plutôt bluffant comme le montre la vidéo disponible ici. Le PDG de la société, David Hanson, indique que Sophia est destinée à être employée dans les interactions homme-robot, notamment dans les domaines de la santé et du service client.

L’objectif du projet est d’ailleurs clairement décrit par le chef d’entreprise lui-même: grâce à ses facultés de compréhension et de mémorisation des conversations, ce robot devra être capable de s’améliorer continuellement pour, in fine, devenir aussi « consciente et créative que n’importe quel être humain ».

D’ailleurs le fait d’attribuer une capacité de créativité aux robots, et plus précisément aux intelligences artificielles, fait toujours l’objet de débats. Ceci amenant la question suivante : est-ce qu’une machine créée par l’homme, reposant sur des algorithmes aussi aléatoire soient-ils, peut-être douée de créativité, tel un artiste ?

Le débat reste entier et pour l’instant aucune intelligence artificielle développée à ce jour ne permet d’affirmer que les machines peuvent rivaliser avec les talents artistiques de l’homme.

Toutefois notons que Google, via son projet Magenta a déjà laissé s’exprimer l’intelligence artificielle dans le domaine de « l’art », en dévoilant le premier morceau de musique jamais réalisé par une intelligence artificielle.

Ces différentes nouvelles dans le monde des IA nous permettent d’affirmer que leur développement est plus que jamais concret, et d’actualité, que ce soit dans le cadre de projets gérés par de puissantes multinationales ou dans des entreprises plus discrètes.

Alors, avec les différentes avancées dans ce domaine, doit-on, plus que jamais, faire preuve de défiance vis-à-vis de ces créations, ou au contraire en attendre de considérables évolutions positives pour notre société ?

Projetons-nous dans notre avenir, aux côtés des intelligences artificielles

Afin d’apporter des éléments de réponse à cette vaste question, et comme cité dans la première partie de cet écrit, le site américain de vulgarisation scientifique « Wait But Why » propose un 2ème article très intéressant, s’appuyant sur une réflexion poussée sur l’avenir de l’humanité vis-à-vis du développement de l’intelligence artificielle.

La réflexion proposée s’appuie sur la consultation et le sondage de plusieurs éminentes personnalités du monde de la science et des nouvelles technologies. Parmi celles-ci on peut citer :

- Raymond Kurzweil, ingénieur, chercheur, futurologue américain, directeur de l’ingénierie chez Google

- Nick Bostrom, philosophe Suédois, fondateur de la WTA (World Transhumanist Association)

- Ben Goertzel, chercheur américain, notamment PDG de Novamente LLC, compagnie cherchant à mettre au point une intelligence artificielle de type AGI (en Français « Intelligence Artificielle Forte)

- Paul Allen, informaticien et homme d’affaires américain cofondateur de la société Microsoft avec Bill Gates

- Bill Joy, informaticien américain, cofondateur de la société Sun Microsystems

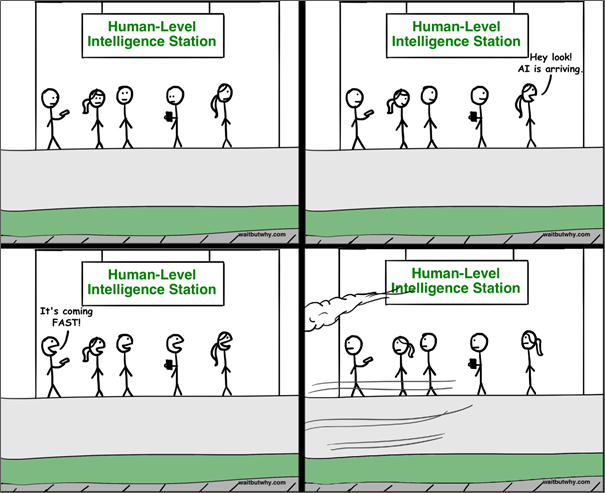

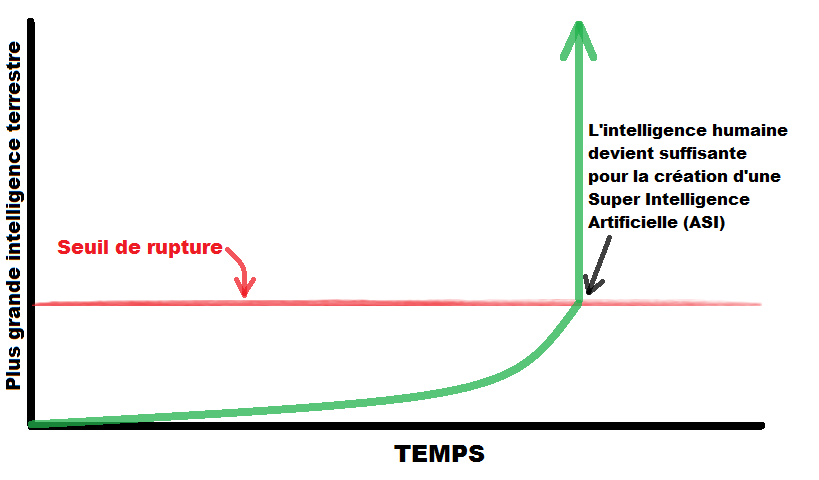

Pour comprendre ce à quoi nous pourrions être confrontés dans plusieurs dizaines d’années, rappelons le concept de singularité technologique : il désigne le moment à partir duquel l’humanité aura franchi un seuil d’évolution technologique bien particulier. Une fois ce seuil hypothétique et théorique franchit, l’évolution technologique sera d’une telle rapidité que l’humanité pourrait être dépassée par ses propres créations.

Il pourrait en résulter alors de nombreuses conséquences imprévisibles. Parmi celles-ci, la possibilité que l’homme ait créé, au moment de cette singularité, son ultime invention, celle n’ayant plus besoin de l’intervention humaine car capable de s’auto entretenir et améliorer, pour finalement évoluer vers une intelligence, non seulement supérieure à l’espèce humaine, mais s’accroissant ensuite de façon exponentielle.

Cette potentielle évolution fulgurante de l’intelligence artificielle nous amène donc à réfléchir sur ses conséquences pour notre espèce : après avoir passé ce fameux point de singularité, devrait-on forcément s’attendre à un scénario catastrophe, ou pourrait-on tirer parti de cette révolution (à tous points de vue) pour la tourner à notre avantage ?

Science sans conscience ?

Une intelligence artificielle est par définition une création artificielle, une machine, qui ne dispose pas de conscience ni de notion du bien ou du mal. Toute sa « personnalité » va finalement découler du code, des algorithmes, aussi aléatoires soient-ils, sur lesquels elle se base pour évoluer.

L’enjeu est donc d’éviter le scénario où une machine serait amenée à se détourner de ce pour quoi elle a été conçue (à la manière de l’IA VIKI dans le film « I, Robot », illustrée ci-contre).

Afin d’éviter cela, tous les choix auxquels elle pourra être confrontée devront être anticipés et associés à d’éventuelles mesures préventives.

Non pas que la machine soit malveillante par nature, mais au contraire, elle réalisera les tâches pour lesquelles elle est programmée, en mettant en œuvre tout type de moyens pour y parvenir, ne distinguant pas naturellement la différence entre une action morale ou immorale.

La déviance d’une machine artificiellement intelligente peut provenir de 2 facteurs principaux :

- Une mauvaise conception de celle-ci, avec des ‘garde-fous’ insuffisants

- Une conception volontairement malveillante, par des personnes mal intentionnées

Certaines œuvres de science-fiction nous suggèrent volontiers un troisième scénario ou la machine serait subitement, d’elle-même, devenue malveillante. Cela reviendrait à dire que la machine s’est dotée d’une véritable conscience et personnalité ce qui, à l’état de nos connaissances actuelles, semble relever uniquement de la science-fiction.

En revanche le scénario d’une mauvaise conception aboutissant à une machine totalement hors de contrôle semble extrêmement probable.

Pour illustrer ce cas, revenons sur l’actualité. L’intelligence artificielle de Microsoft, baptisée Tay, un robot conversationnel (ou chatbot), s’est récemment exprimée avec des propos racistes sur Twitter. Certes il s’agissait là du résultat de nombreux internautes essayant de la pousser à la faute en lui proposant des conversations absurdes, mais initialement cette dérive n’était pas voulue ni peut être même prévue par Microsoft, qui a d’ailleurs finalement décidé de la mettre hors ligne.

On comprend donc que la conception d’un simple chatbot (intelligence artificielle de type ANI) est déjà complexe ne serait-ce que pour cadrer ses agissements potentiels, mais qu’en est-il de la programmation, certes dans un avenir plus lointain, d’une ASI (ou Super Intelligence Artificielle) ? N’est-il pas prétentieux de dire que notre intelligence humaine pourra prévoir et sécuriser l’ensemble des cas d’action d’une telle intelligence ?

En admettant que nous en soyons capables, un code universel de morale devrait être convenu, et être évolutif pour correspondre aux évolutions de notre société. Celui-ci sera la base sur laquelle devra reposer toute conception d’intelligence artificielle évoluée (de type AGI ou ASI).

Il est évident que la mise en place d’un tel code, universellement accepté, sera un véritable défi à relever. Au-delà d’un tel code, c’est sans doute également une toute nouvelle science qui devrait voir le jour, à la frontière entre technologie, philosophie et psychologie.

Qui de la législation ou de la première Super Intelligence sortira le premier ?

Il est évident que pour que ce nouveau cadre juridico-technologique nous protège d’éventuels dérapages des IA, celui-ci devra être mis en place plus rapidement que ne se développent déjà les projets purement technologiques.

Cela paraît évident et pourtant, rappelons que des projets dans le domaine de l’intelligence artificielle voient le jour, dans la plus grande discrétion, aux 4 coins du monde, sans être régis par une quelconque autorité ou législation centrale.

D’ailleurs, selon un sondage réalisé auprès des plus grands experts sur ce domaine, l’arrivée de la première super intelligence (celle qui pourrait être à l’origine de la fameuse singularité technologique) pourrait voir le jour dès 2060, selon la valeur médiane des estimations données par différentes personnalités du monde de la science et des nouvelles technologies.

Jusque-là, les arguments en faveur d’une forte méfiance vis-à-vis du développement des IA semblent les plus nombreux.

Toutefois rappelons que le but ultime du développement des intelligences artificielles, qui pour l’instant ne s’imposent pas à nous comme une nécessité, est de nous proposer des performances qui nous permettent de repousser les limites de nos propres connaissances (notamment dans les sciences), mais également de développer les services à la personne, et remplacer toutes sortes de tâches considérées ‘ingrates’ (à tort ou à raison) par des robots qui n’ont pas de notion de pénibilité du travail.

Pour arriver à un tel objectif de développement de l’IA, tout en étant capable de garder la maîtrise de ces technologies du futur, il faut dès maintenant se préparer à en définir le cadre et les principes garantissant notre propre sécurité. Un vrai travail de réflexion est donc à effectuer quant aux mesures permettant de sécuriser ces intelligences. On peut distinguer deux grands types de mesures :

- Les mesures conceptuelles : Avec par exemple la mise en place d’un code éthique universel pour les intelligences artificielles, base sur laquelle reposera le comportement et donc le code contenu par ces futures machines.

- Les mesures technologiques : La possibilité d’intégrer des procédures d’urgences pouvant pallier à toute dérive identifiée sur les machines dotées d’IA.

Pour illustrer ce dernier concept, des chercheurs de Google ont récemment évoqué une idée, dans le cadre du projet de mise en place de l’IA développée par Deepmind. Le principe serait simplement d’intégrer à toute intelligence artificielle, un mécanisme de blocage instantané de cette intelligence, une sorte de disjoncteur pour IA.

Un domaine en plein développement dont les résultats sont déjà perceptibles

Au vu des éléments évoqués ci-dessus, il est maintenant plus aisé de comprendre les récentes déclarations de l’astrophysicien britannique Stephen Hawking, du fondateur de Microsoft, Bill Gates ou encore du PDG de Tesla, Elon Musk, qui ont émis leurs craintes sur notre avenir aux côtés de ces technologies.

D’ailleurs les réticences quant au développement des robots humanoïdes sont déjà au goût du jour, et ce n’est pas Google qui dira le contraire. En effet, le groupe Alphabet auquel il appartient, à récemment décidé de se séparer de Boston Dynamics, suite à de nombreux commentaires faisant état de scepticisme vis-à-vis des capacités démontrées par ses robots, de plus en plus agiles, au point de se mouvoir comme les êtres humains ou certains animaux quadrupèdes.

Rappelons que nous sommes déjà dans une phase avancée du développement des intelligences artificielles puisque sur certains domaines restreints, la machine bat déjà l’intelligence humaine, comme sur le jeu de Go, réputé pour ses combinaisons de jeu quasi-infinies, où l’IA Alphago (développée par Google Deepmind) à récemment battu 3 fois d’affilées le champion Lee Sedol.

Il est donc important de prendre conscience que certaines inventions imaginées dans les œuvres de science-fiction les plus avant-gardistes, font déjà, et pourront prochainement davantage faire partie de la réalité.

En admettant que les équipes travaillant, à travers le monde, sur l’intelligence artificielle, soient toutes animées d’un esprit de bienveillance, le risque d’être dépassé par leur propre création est tout de même plausible. Il est donc plus que jamais temps de réfléchir avant d’agir, car autrement notre intelligence pourrait bien être totalement supplantée par nos propres créations.